Das Problem mit 500er-Statuscodes

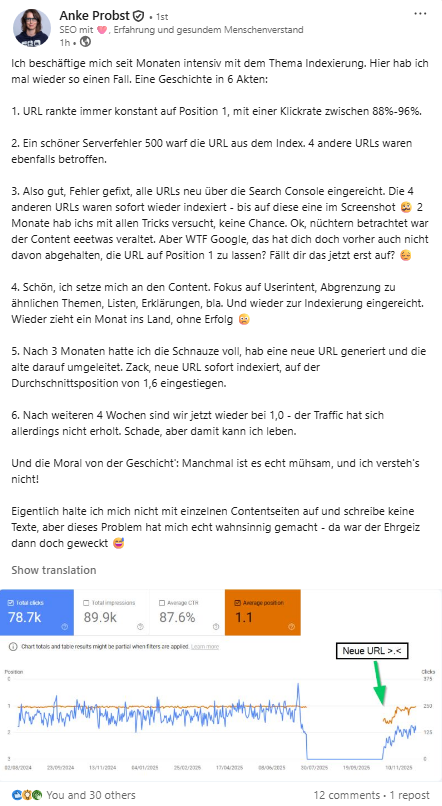

Anke Probst beschreibt es in ihrem LinkedIn-Post sehr treffend: Wenn deine Website zu viele 500er-Statuscodes ausgibt, kann Google damit beginnen, Seiten aus dem Index zu entfernen. Besonders kritisch sind jedoch Serverfehler bei der robots.txt. Liefert diese Datei 500er-Statuscodes, kann das im schlimmsten Fall zur vollständigen Deindexierung der gesamten Website führen. Deshalb ist das Tracken und Monitoring sehr wichtig.

Lösung

Der Website Status Code Crawler von Apify hilft dabei, den Statuscode von Webseiten zu überprüfen. Er crawlt alle angegebenen URLs und sammelt die HTTP-Statuscodes, die von den Servern zurückgegeben werden. Das Tool ist besonders nützlich, um fehlerhafte Seiten wie 404 (nicht gefunden) oder 500 (Serverfehler) zu erkennen.

Features

- Crawlt Webseiten und gibt den HTTP-Statuscode zurück.

- Unterstützt benutzerdefinierte URLs: Definiere deine Start-URLs und den maximalen Crawltiefe.

- Ermittelt Statuscodes für jede URL: Die gesammelten Daten beinhalten den Statuscode jeder besuchten URL.

- Erkennt Fehlerseiten: Du kannst Fehlerseiten wie 404, 500 usw. mit minimalem Aufwand identifizieren.

Nutzung des Status-Code Crawlers

Um den Website Status Code Crawler zu verwenden, folge diesen einfachen Schritten:

1. Apify Actor einrichten

- Besuche Apify und melde dich an.

- Gehe zum Apify Store und finde den Website Status Code Crawler.

- Klicke auf "Try for free", um den Actor auszuführen.

2. Eingabeparameter definieren

Du kannst den Crawler mit den folgenden Eingaben steuern:

- start_urls: Eine Liste von URLs, die der Crawler besuchen soll.

- max_depth: Bestimmt die maximale Crawltiefe. Das bedeutet, wie viele Seiten vom Startpunkt aus weiter verfolgt werden. Eine Tiefe von 1 crawlt nur die Start-URLs, Tiefe 2 crawlt die Start-URLs sowie alle von diesen Seiten verlinkten Seiten.

3. Apify Actor ausführen

- Klicke auf den Button „Run“ in Apify, um den Actor zu starten.

- Die Ausgabe wird dir den HTTP-Statuscode für jede gecrawlte URL anzeigen.

4. Daten exportieren

Nach Abschluss der Ausführung kannst du die extrahierten Daten (URLs und Statuscodes) als JSON oder CSV herunterladen. So hast du einen Überblick über alle Seiten und deren Status.

Beispiel-Output

Der Output des Crawlers sieht etwa so aus:

- url: Die besuchte URL.

- status: Der HTTP-Statuscode der URL. Ein Wert von

200bedeutet, dass die Seite erfolgreich geladen wurde, während Werte wie404und500Fehler anzeigen.

5. Fehlerseiten erkennen

Ein wichtiger Anwendungsfall für diesen Crawler ist die Erkennung von fehlerhaften Webseiten. Seiten mit einem Statuscode größer als 200 (z.B. 404 oder 500) signalisieren Fehler und können für die weitere Analyse weiterverarbeitet werden.

6. Weitere Nutzungsmöglichkeiten

- Integration mit n8n: Du kannst den Apify-Actor in n8n integrieren, um einen automatisierten Workflow zu erstellen, der regelmäßig nach fehlerhaften Seiten sucht und bei Fehlern eine Benachrichtigung auf Slack oder Telegram sendet.

- Downloade hier die JSON Import Datei um diese bei n8n zum importieren

- Monitoring von Webseiten: Der Crawler ist besonders nützlich für das Monitoring von Webseiten, die regelmäßig überprüft werden müssen, um sicherzustellen, dass keine fehlerhaften Seiten zurückgegeben werden.

Fazit

Der Website Status Code Crawler von Apify ist ein einfach zu bedienendes Tool, das dir hilft, den Zustand deiner Webseiten zu überwachen. Egal, ob du Fehlerseiten identifizieren oder ein vollständiges Crawling durchführen möchtest, dieser Actor bietet eine schnelle und effiziente Lösung.

Du kannst das Tool weiter anpassen und erweitern, um deine Anforderungen zu erfüllen, oder es in Workflows wie n8n integrieren, um eine regelmäßige Überprüfung zu automatisieren.